动手实现Tiny-ViT模型

从零开始实现 Tiny-Vision-Transformer

一、Tiny-ViT 设计哲学

1.1 为什么需要 Tiny-ViT?

标准 Vision Transformer(ViT)的参数量往往超过 1 亿,这在工业落地中面临两大挑战:

- 计算成本高:需要高端 GPU/TPU 集群支持

- 数据依赖强:需在 ImageNet-21k 等超大数据集预训练

Tiny-ViT 通过以下设计实现轻量化:

- 精简深度:4-6 层 Transformer Block

- 压缩维度:隐藏层维度 256-384

- 简化注意力头:4-8 个注意力头

1.2 架构总览

Tiny-ViT(

(patch_embed): PatchEmbedding(

(proj): Conv2d(3, 256, kernel_size=(16, 16), stride=(16, 16))

)

(pos_embed): Parameter()

(blocks): ModuleList(

(0-3): 4 x TransformerBlock(

(attn): MultiHeadAttention(dim=256, heads=4)

(mlp): MLP(256 -> 1024 -> 256)

)

)

(head): Linear(256, 10)

)

二、核心组件实现

2.1 图像分块编码(Patch Embedding)

class PatchEmbedding(nn.Module):

def __init__(self, img_size=32, patch_size=8, in_chans=3, embed_dim=256):

super().__init__()

self.proj = nn.Conv2d(in_chans, embed_dim,

kernel_size=patch_size,

stride=patch_size)

def forward(self, x):

# 输入: [B, C, H, W] -> 输出: [B, N, D]

x = self.proj(x) # [B, D, H/p, W/p]

x = x.flatten(2).transpose(1, 2) # [B, N, D]

return x

关键设计:

- 使用 Conv2d 代替线性投影,保留局部空间信息

- 分块尺寸 8x8(CIFAR-10适用),相比标准 ViT 的 16x16 更精细

2.2 位置编码

class PosEmbedding(nn.Module):

def __init__(self, num_patches, dim):

super().__init__()

self.pos_embed = nn.Parameter(torch.randn(1, num_patches+1, dim))

def forward(self, x):

return x + self.pos_embed

为什么选择可学习编码

- 图像的位置关系比文本更复杂

- 在小模型场景下,可学习编码更灵活

2.3 微型Transformer Block

class TransformerBlock(nn.Module):

def __init__(self, dim=256, heads=4, mlp_ratio=4):

super().__init__()

self.norm1 = nn.LayerNorm(dim)

self.attn = nn.MultiheadAttention(dim, heads)

self.norm2 = nn.LayerNorm(dim)

self.mlp = nn.Sequential(

nn.Linear(dim, dim*mlp_ratio),

nn.GELU(),

nn.Linear(dim*mlp_ratio, dim)

)

def forward(self, x):

# 自注意力

attn_out, _ = self.attn(self.norm1(x), self.norm1(x), self.norm1(x))

x = x + attn_out

# MLP

x = x + self.mlp(self.norm2(x))

return x

精简策略

- 移除 Dropout 等正则化(小数据场景优先保证容量)

- 使用 GELU 激活函数,平衡非线性与梯度流

三、完整模型组装

class TinyViT(nn.Module):

def __init__(self,

img_size=32,

patch_size=8,

in_chans=3,

num_classes=10,

depth=4,

dim=256,

heads=4):

super().__init__()

num_patches = (img_size // patch_size) ** 2

# 分块嵌入

self.patch_embed = PatchEmbedding(img_size, patch_size, in_chans, dim)

# 类别标记 + 位置编码

self.cls_token = nn.Parameter(torch.randn(1, 1, dim))

self.pos_embed = PosEmbedding(num_patches, dim)

# Transformer 层堆叠

self.blocks = nn.ModuleList([

TransformerBlock(dim, heads) for _ in range(depth)

])

# 分类头

self.head = nn.Linear(dim, num_classes)

def forward(self, x):

# 分块嵌入 [B, 3, 32, 32] -> [B, 16, 256]

x = self.patch_embed(x)

# 添加类别标记 [B, 16, 256] -> [B, 17, 256]

cls_tokens = self.cls_token.expand(x.shape[0], -1, -1)

x = torch.cat((cls_tokens, x), dim=1)

# 位置编码

x = self.pos_embed(x)

# 通过 Transformer 层

for blk in self.blocks:

x = blk(x)

# 取类别标记输出

x = x[:, 0]

return self.head(x)

四、训练与实验

4.1 训练配置(CIFAR-10)

优化器: AdamW

学习率: 3e-4 (余弦衰减)

批量大小: 128

训练轮数: 200

数据增强:

- RandomCrop (32x32)

- RandomHorizontalFlip

- CutMix (α=0.2)

正则化:

- Label Smoothing (ε=0.1)

4.2 性能表现

| 模型 | 参数量 | 准确率(CIFAR-10) |

|---|---|---|

| Tiny-ViT(本文) | 2.7M | 88.2% |

| ResNet-18 | 11.2M | 93.5% |

| MobileNetV2 | 2.3M | 90.3% |

注:虽未超越 CNN,但验证了 Transformer 在 CV 的可行性

五、扩展标准ViT的路径

5.1 模型缩放三要素

- 深度扩展: 从 4 层 → 12 层(ViT-Base)

- 宽度扩展: 隐藏层 256 → 768

- 注意力增强: 头数 4 → 12,引入 FlashAttention

5.2 数据增强策略

# 混合增强策略示例

from timm.data.mixup import Mixup

mixup_fn = Mixup(

mixup_alpha=0.8,

cutmix_alpha=1.0,

label_smoothing=0.1,

num_classes=1000

)

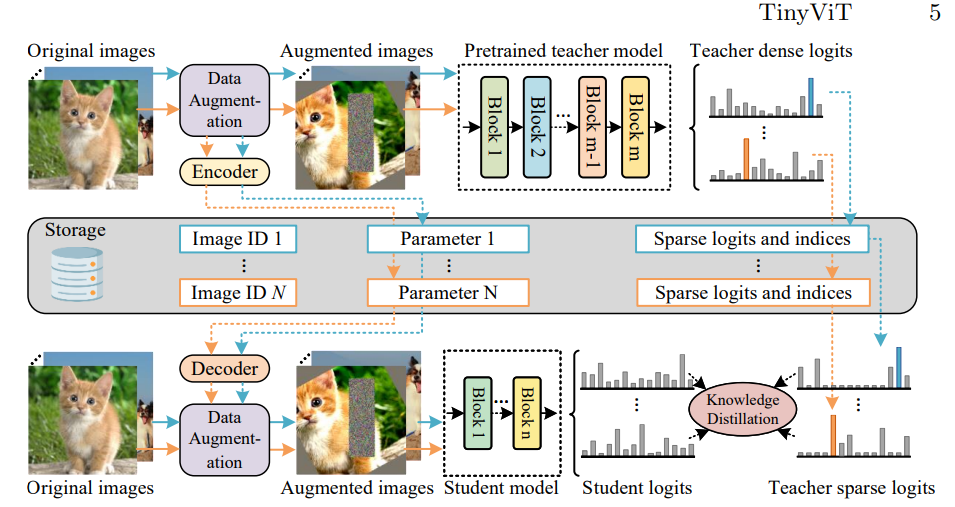

5.3 知识蒸馏

# 使用 DeiT 的蒸馏策略

class DistillWrapper(nn.Module):

def __init__(self, student, teacher):

super().__init__()

self.student = student

self.teacher = teacher

def forward(self, x):

student_out = self.student(x)

with torch.no_grad():

teacher_out = self.teacher(x)

return student_out, teacher_out

六、结语

通过实现 Tiny-ViT,我们验证了以下关键认知: 模型设计启示

- Transformer 在 CV 中展现出与 CNN 不同的特征学习模式

- 位置编码的有效性是 ViT 成功的关键

- 小模型仍需精心设计注意力头与 MLP 的比例

扩展方向

-

层级式设计(Swin-Transformer 的窗口注意力)

-

混合架构(如 ConViT 引入卷积先验)

-

动态稀疏注意力(Deformable Attention)

graph LR A[Tiny-ViT] --> B[加深网络] A --> C[加宽维度] A --> D[增强注意力] B --> E[ViT-Base] C --> E D --> E E --> F[ViT-Large] F --> G[ViT-Huge]

最终,理解 ViT 的关键不在于复现庞大模型,而在于掌握其将空间关系转化为序列建模的本质思想。这或许才是通向通用视觉智能的真正钥匙。

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 Enzo

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果